Ep3-R(新章)|Large-Scale MD with LAMMPS (Kokkos + ML-IAP)

追記(2025-12-13)

本シリーズは方針を更新し、まず LLZO粒界におけるLi偏析・集積(短絡の前駆現象) を優先して解析します。最新ロードマップは 研究ノート(ハブ) をご覧ください。

本稿の内容(LAMMPS + Allegro のGPUスケーリング実測)は、粒界編でもそのまま基礎ベンチとして利用します。

PyTorch で学習した ML-IAP(Allegro)モデルを LAMMPS に投入し、まずは 単一ノードでの GPU スケーリング実測(1GPU / 4GPU)を取得しました。次のステップとして、H200 NVL(4GPU / 8GPU)でも同一入力で再計測し、NVLink/NVSwitch 環境でのスケーリングを公開していきます。

1. 実行条件

1.1 目標シナリオ(本稿で目指す到達点)

- LLZO 粒界(grain boundary)を含む長時間 MD(NVT、数 ns クラス)

- 温度 : 300 K / 500 K 比較

- デバイス : H200 NVL(4 GPU / 8 GPU)

- 解析 : Li の偏析・拡散経路・クラスター(短絡の前駆現象)を “回せる 3D” で可視化

- (後続ステップ)粒界で得た知見(偏析・局在・拡散)を、LLZO/Li 界面シナリオ(短絡/フィラメント理解)へ接続

1.2 今回の実測ベンチ(A100 PCIe ×4 単一ノード)

- 目的 : LAMMPS + Allegro の 1GPU / 4GPU スケーリングを実測し、基礎スループットを確定

- ハードウェア : NVIDIA A100 80GB PCIe ×4(単一ノード)

- LAMMPS :

LAMMPS (10 Sep 2025) - ML-IAP : Allegro(NequIP)TorchScript モデル(

.nequip.pth) - 実行形態 : MPI ランク = GPU 枚数、OpenMP = 1

- 入力 : DeepMD 由来の LAMMPS 入力を Allegro 用に変換した

in.allegro_bench.lmp - ステップ数 : 200,000 steps

※ 本稿タイトルでは Kokkos にも触れていますが、今回の A100 実測は「単一ノード GPU スケーリングの基礎値」を出す目的であり、ボトルネックは主に ML-IAP(pair 計算)側にあります。次回の H200 NVL(4/8GPU)追記では、NVLink/NVSwitch とあわせて Kokkos 設定・実行条件も整理して提示します。あわせて、粒界編(Li偏析)で必要になる大規模セルへ展開する前提として、本稿ベンチを“比較軸”として維持します。

2. 速度とスケーリング(実測)

LAMMPS ログの Loop time と Performance(katom-step/s)から、1GPU と 4GPU のスループットを比較しました(同一入力・同一ステップ数)。

| GPUs | Steps | Loop time [s] | ns/day | timesteps/s | katom-step/s | Total wall time |

|---|---|---|---|---|---|---|

| 1 | 200000 | 8166.02 | 2.116 | 24.492 | 113.666 | 2:16:08 |

| 4 | 200000 | 2468.72 | 7.000 | 81.014 | 377.848 | 0:41:11 |

※ 比較は「同一入力・同一ステップ数」で実施し、スループットは LAMMPS が出力する Performance(katom-step/s)表記に従っています。

Speedup (4GPU / 1GPU) = 3.324×(katom-step/s 基準)

Scaling efficiency = 83.1%(= Speedup / 4)

この結果は A100 PCIe(NVLink なし)での単一ノード基礎スケールです。次は同一入力・同一モデルで H200 NVL(4GPU / 8GPU)を測り、NVLink/NVSwitch 環境でスケーリングがどこまで伸びるかを実測で示します(本稿へ追記予定)。このスケーリング実測は、粒界×Li偏析(前駆現象)を大規模に回すための基盤データとして位置づけます。

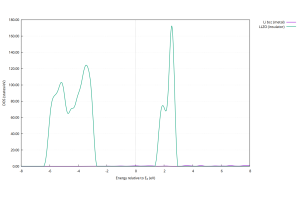

3. 可視化例

4. まとめ

QE → ML-IAP(Allegro)→ LAMMPS の流れを一本化することで、DFT→AI-MD の更新サイクルを高速化できます。

今回の実測では、A100×4 単一ノードにおいて 4GPU で 3.324×(効率 83.1%)のスケーリングを確認しました。

次の更新では、H200 NVL(4GPU/8GPU)での同一ベンチを追加し、NVLink/NVSwitch 環境での実効性能を公開します。

また本シリーズは方針更新し、まず LLZO粒界×Li偏析(短絡の前駆現象)を優先して進めます(最新ロードマップはハブ記事参照)。

Founding 5 PoC では、この AI-MD 環境を無償で試用いただけます。

現在の進行状況と今後の予定(Ep3-R アップデート)

本シリーズは方針を更新し、まず LLZO粒界×Li偏析(短絡の前駆現象) を優先して解析します(ハブ記事)。その上で、本稿では「ML-IAP(Allegro)+ LAMMPS」による大規模 AI-MD を回すためのGPUスケーリング基盤を固めています。現在は GPU 版 Quantum ESPRESSO 7.4.1 による DFT AIMD と、その出力から energy・forces・stress を含むラベル付き extxyz データを生成するパイプライン整備を進めています。並行して、Allegro の試験学習モデルを LAMMPS に投入し、入出力形式・力の整合性・温度制御などの AI-MD フロー検証を段階的に行っています。

今回のアップデートでは、DeepMD 由来の LAMMPS 入力を Allegro 用に置換したベンチ入力を用いて、A100×4 単一ノードで 1GPU / 4GPU の実測スループットを取得しました(4GPU: 377.848 katom-step/s)。この「同一入力で比較できるベンチの型」をそのまま H200 NVL(4GPU/8GPU)へ持ち込み、NVLink/NVSwitch 環境でのスケーリングを実測で追記していきます。

今後は、DFT データセットをまず LLZO 粒界(grain boundary)へ拡張(優先)し、ついでバルク LLZO・バルク Li・温度や Li カバー率の異なる界面、軽いひずみを加えた構造へと順次拡張していきます。それらに対応する ML-IAP モデルを再学習しながら、H200 NVL 構成での長時間 NVT シミュレーションと 3D 可視化へ踏み込みます。最終的には、粒界で得た知見(偏析・局在・拡散)を界面シナリオへ接続し、短絡に至るメカニズムを “回せる 3D” 可視化とあわせて順次反映していく予定です。