CPU で材料計算を回しているなら——いまが GPU への乗り換え時。A100 実測を踏まえた H200 NVL 141GB(PCIe)導入ガイド

要約:量子化学・固体計算を CPU で回している研究室では 1 本の SCF にも何十分もかかるのが日常です。この記事では Quantum ESPRESSO(QE)GPU 版を A100 80GB ×4 機で実測し、最短 47.35 秒を確認しました。比較用に CPU 64 MPI では 10分58.33秒(658.33 秒)で、約 13.9× 高速化です。さらに H200 NVL 141GB(PCIe)×4 なら、HBM 帯域と容量の伸びから おおむね 1.7〜2.3×(推定)短縮が期待できます。つまり「分」単位の計算が「十数秒」へ。

TL;DR:CPU 64MPI ≈ 10分58秒 → A100×4 ≈ 47秒(13.9×)。H200×4(推定)で 20〜30 秒台のレンジ。

目次

- なぜ今 GPU なのか(Gaussian ユーザーにも刺さる話)

- テスト環境(読者マシン比較用スペック表)

- ベンチマーク条件(QE / Au 表面「DEISA pw」)

- 結果:CPU vs GPU の実測比較と 1 / 2 / 4 GPU スケール

- H200 NVL 141GB ×4 はどこまで短縮できるか(推定)

- Gaussian ユーザーへの現実的な移行ライン

- 再現方法とスクリプト

- どの構成を選ぶか:1 / 2 / 4 GPU の目安

1. なぜ今 GPU なのか(Gaussian ユーザーにも刺さる話)

Gaussian を長年お使いの方ほど CPU を積み増すことで凌いできましたが、表面・周期境界系では FFT/BLAS とメモリ帯域がボトルネックになりがちです。QE(平面波・擬ポテンシャル)はここを GPU に逃がせます。FFT、ハミルトニアン作用、密度生成など重い箇所を GPU に載せ、PCIe/NVLink の転送を抑える実装が成熟。結果として、A100×4 実測で「分」が「秒」になりました。

2. テスト環境(読者マシン比較用スペック表)

| 項目 | 内容 |

|---|---|

| GPU | NVIDIA A100 80GB ×4(PCIe) |

| GPU ドライバ / CUDA | Driver 575.57.08 / CUDA 12.9(nvidia-smi 抜粋) |

| CPU | Intel Xeon Gold 6430 ×2(合計 64 コア, HT 無効) |

| メモリ | 約 512 GB |

| OS | Ubuntu 24.04.2 LTS(Noble) |

| コンテナ | Apptainer(Singularity) + QE 7.3.1 SIF(GPU/MKL) |

| MPI / UCX(SIF 内) | Open MPI 4.1.2rc4、UCX 1.12.1 |

3. ベンチマーク条件(QE / Au 表面「DEISA pw」)

- コード:Quantum ESPRESSO 7.3.1(GPU/CPU いずれも SIF で固定)

- 入力:DEISA pw(

ausurf.in) Au 112 原子、ecutwfc=25 Ry、nbnd=800、nk=2、Marzari–Vanderbilt smearing - メトリクス:ログ末尾の

PWSCF : ... WALL(ウォールクロック)

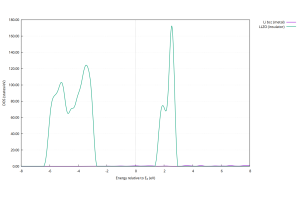

4. 結果:CPU vs GPU の実測比較と 1 / 2 / 4 GPU スケール

CPU(MPI 並列)ウォールクロック

| 並列 | WALL(実測) | 秒換算 | ログ |

|---|---|---|---|

| 8 MPI | 31m57.35s | 1917.35 s | logs/pw_np8.log |

| 16 MPI | 18m21.05s | 1101.05 s | logs/pw_np16.log |

| 32 MPI | 13m0.48s | 780.48 s | logs/pw_np32.log |

| 64 MPI | 10m58.33s | 658.33 s | logs/pw_np64.log |

GPU(実測)ウォールクロック

| GPU 数 | 設定の要点 | WALL(実測) | CPU64MPI 比 |

|---|---|---|---|

| 1 GPU | npool=1 | 151.38 s | 約 4.35× 高速 |

| 2 GPU | npool=2 | 78.56 s | 約 8.38× 高速 |

| 4 GPU | npool=2 + NUMA 最適化 | 47.35–48.90 s | 13.9× 高速(47.35 s 基準) |

注意:不適切な設定(CUDA IPC 無効、npool 不整合、固定バインド等)では 4 GPU でも 80–150 秒台まで悪化。NUMA と GPU の対応付け(ppr:numa)、CUDA IPC、npool 整合が決定打。

5. H200 NVL 141GB ×4 はどこまで短縮できるか(推定)

- メモリ起因の待ち:HBM 容量・帯域増で FFT/密度更新のスタール減(約 1.6–2.4×)

- 計算スループット:FP64/行列演算改善(約 1.4–1.8×)

- 合成レンジ:A100×4 の 47.35 s を基準に 1.7–2.3× 短縮 → おおよそ 21–28 秒

※ 推定値。ドライバ・QE バージョン・MPI/UCX・I/O 等で変動。VRAM 141GB/GPU は「バンド分割回避」「より大きな系を 1 ノードに収める」運用面メリットが大きい。

6. Gaussian ユーザーへの現実的な移行ライン

- 住み分け:分子系・局在基底は Gaussian、表面・周期系・金属は QE(平面波)

- 入力:初期構造は Gaussian/Babel 等で作り QE の

.inへ変換。原子数が増えるほど GPU の旨味 - 環境固定:Apptainer(Singularity)で SIF 固定 → 誰が回しても速度が安定

7. 再現方法とスクリプト

GPU 実行(抜粋)

#!/usr/bin/env bash

# 例: 4GPU / npool=2 / NUMA最適化

./run_qe_gpu.sh -g 4 -p 16 -n 2 -i ausurf.in -s qe-7.3.1.sif -m numa -o logs/pw_gpu_g4.log

CPU(MPI)実行(抜粋)

#!/usr/bin/env bash

# 例: SIF=qe-7.3.1-mkl-openmpi.sif で 64 MPI

mpirun -np 64 --map-by core:PE=1 --bind-to core apptainer exec --cleanenv qe-7.3.1-mkl-openmpi.sif pw.x -in ausurf.in | tee logs/pw_np64.log

ログ抽出ワンライナー

grep -H 'PWSCF :' logs/*.log \

| sed -E 's#.+/(.+)\.log: *PWSCF *: *([0-9]+)m([0-9]+\.[0-9]+)s .*WALL#\1,\2m\3s#; t; s#.+/(.+)\.log: *PWSCF *: *([0-9]+\.[0-9]+)s .*WALL#\1,\2s#'

8. どの構成を選ぶか:1 / 2 / 4 GPU の目安

- 1 GPU(H200 141GB):小〜中規模の周期系、試行錯誤を速く回す用途。多くのモデルが 1 GPU に収まり、分割なしで簡潔。

- 2 GPU:npool=2 を素直に効かせたいとき。NVLink 有無にかかわらず NUMA とランク配置を正しく。

- 4 GPU:今回のように ~3.1× までスケール。H200 なら 十数秒〜30 秒台を狙えるレンジ。

お問い合わせ・ご相談:H200 NVL 141GB(PCIe)1/2/4 GPU サーバの構成設計、ベンチ再現、導入後の運用(キューイング、コンテナ固定、ユーザー教育)まで支援します。既存 Gaussian ワークフローとの住み分け・橋渡しもご提案可能です。